未来发展

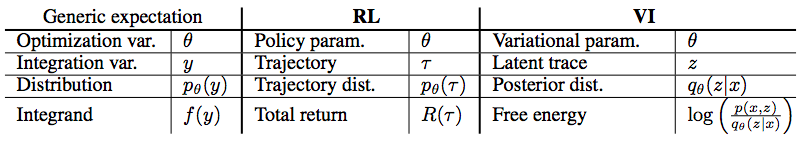

现在的深度强化学习中很多的模型是,强化学习中部分研究成果深度学习化的结果。但最令人兴奋的是,一些新的想法,例如强化变分推断,在Theophane Weber 等人的论文(http://arkitus.com/files/nips-15-weber-reinforced-inference.pdf)中,就将 VI 和 RL 进行了联系。参见下图的对比:

他们给出了一种将推断看作是强化学习的视角,这样其实可以让变分推断的研究者们受强化学习技术启发创造出新的推断技术。基线和值函数的方式来进行解释。很多强化学习中其他的概念可用在变分推断中,如时间差分方法或者探索方法,未来这两者间的关系应该能够挖掘到更深的层次,这也使得我们能够找到更多的微分模型和关联技术.

而这篇文章中作者之一 John Schulman 和他 Berkeley 的合作者也有一个进行从计算方法的角度统一化工作,Gradient Estimation Using Stochastic Computation Graphs,将监督学习、非监督学习和强化学习中出现的共同问题进行提炼——损失函数由一个随机变量集上的期望定义,这些随机变量可能是概率模型的变量或者是外部环境的变量。那么使用样本来估计损失函数的梯度就是基于梯度学习的算法的核心。该文给出了随机计算图的形式化定义——包含确定型函数和条件概率分布的有向无环图,并解释如何自动推导出损失函数梯度的无偏估计。得到的算法是对标准反向传播算法的微小改进。该框架可以帮助研究者们开发复杂微妙的模型,方便地加入随机和确定型的操作,如注意力、记忆和行动控制等。

另外深度强化学习在博弈均衡求解中的应用也是令人兴奋的方向之一,随着这些技术的细化和深入,我们将理论计算机和更为实用的机器学习等等技术之间的鸿沟进一步缩小。

未来深度强化学习的发展必定是理论探索和应用实践的深入,这一方面取决于我们深度学习的认识,另一方面则倚重不断地实践。

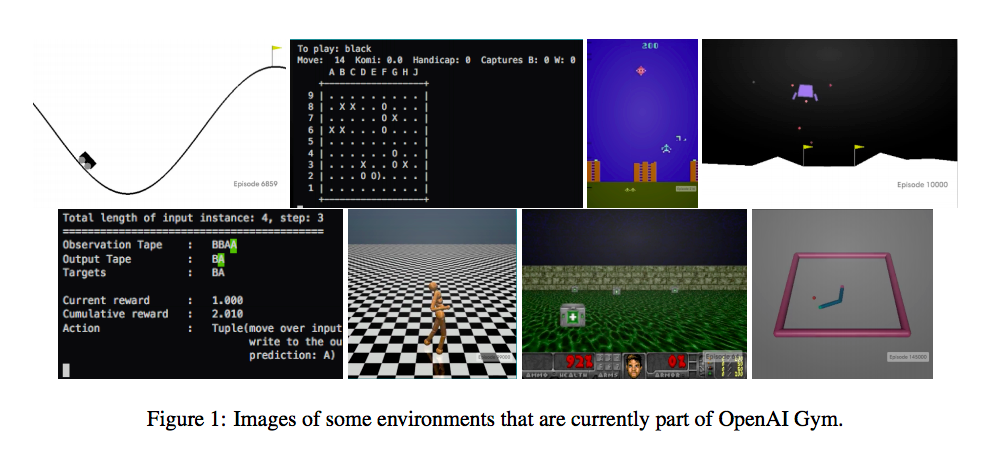

最后,我想推荐一下 OpenAI 的 gym,这是一个强化学习算法测试的环境,可以在上面去尝试自己解决一些问题,同时也可以比对自己方法的优劣。现在也是相当活跃的一个项目,OpenAI 的成员正在不断扩展这个环境,使之满足现在强化学习需要的环境,另外也在征求大家的意见列出最关键的一些相关问题。深度学习有很多的标准的任务可以供大家测试算法,强化学习领域实际上在前几年并不是非常方便进行测试,现在的 Gym 可以算作深度强化学习算法的试金石了。

OpenAI 处于快速发展阶段,其中涉及的 POMDP 环境不断增加:

经典控制和玩具文本:强化学习文献中的小规模的任务

算法:执行诸如多位数字相加,序列逆变等等计算。 大多数这样的任务需要记忆,而难度可通过序列长度调整

Atari 游戏:屏幕图像或者 RAM 作为输入,使用的是 Arcade Learning Environment 作为底层支撑棋盘游戏:当前包括围棋的 9X9 和 19X19 棋盘,Pachi 作为对手

2D 和 3D 机器人:在模拟环境中控制机器人,这些任务使用了 MuJoCo 物理引擎,还有部分来自RLLAB(http://rllab.readthedocs.io/en/latest/)

根据 OpenAI 发布的信息,他们也在扩展 Gym 中其他的环境,如:

多 agent 场景,这些场景中的 agent 之间可以合作或者竞争

Curriculum 学习和迁移学习。当前这些任务还只是初期,后面会形成任务的序列,这样算法可以一个接一个任务地进行训练。这里的设计师创建不断提升难度的任务序列,来适应所需的场景。

真实世界操作:最终目标是将 Gym API 和机器人硬件进行结合,在真实世界中检验强化学习算法

所以从 OpenAI Gym 开始你可以逐步走近到走进这个有意思的领域了,通过实现那些 tricky 的算法来掌握它,对于很多人来说,实现了可以运作的算法代码才是真的懂了(我觉得可能还不够,仍旧有很多的指引需要我们去探索,也许数学证明才是真的理解象征……)

很开心能够有这样的一群人去实践人工智能技术的开放化,对此,我非常的钦佩,也希望能够借助自己的力量来帮助这个项目的成长。

在 Gym 变得更加稳定后, OpenAI 近期向大家征求未来的研究项目,这里可以看到相应的项目和评分。